上課所建置的Hadoop機器: http://140.120.182.143:3000/cluster

VPN: https://cc.nchu.edu.tw/sslvpn/ 因為機器限制只有學校IP才能連進來,不在學校的同學請使用學校VPN連線

VPN連線方式:

- 進入VPN網址: https://nchuvpn.twaren.net/

- 使用學校email(入口網站)帳密登入

- 帳號: 學號@mail.nchu.edu.tw (ex.

g110056XXX@mail.nchu.edu.tw) - 密碼: 入口網站密碼

- 帳號: 學號@mail.nchu.edu.tw (ex.

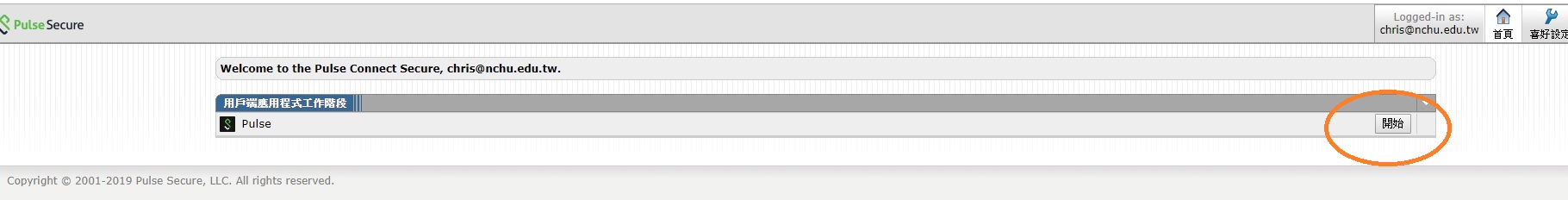

- 點選開始

- 照網頁指示安裝PulseSecure軟體後就可連線,其他詳細資訊可參考 https://cc.nchu.edu.tw/sslvpn/ 安裝說明

ssh hduser@140.120.182.143 -p 1000Account: hduser

Password:

sudo adduser --ingroup hadoop 你的帳號

例如:

sudo adduser --ingroup hadoop yao-chung cd /usr/local/hadoop/

bin/hadoop fs -mkdir -p /user/your_account/

bin/hadoop fs -chown -R your_account:hadoop /user/your_account/exit

ssh 你的帳號@140.120.182.143 -p 1000nano .bashrc

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin

export CLASSPATH=.:$HADOOP_HOME/share/hadoop/common/hadoop-common-2.7.7.jar:$HADOOP_HOME/share/hadoop/mapreduce/hadoop-mapreduce-client-core-2.7.7.jar:$HADOOP_HOME/share/hadoop/common/lib/commons-cli-1.2.jar:$CLASSPATH

source .bashrc- 瀏覽HDFS內容

hadoop fs -ls - 創建目錄夾於HDFS中

hadoop fs -mkdir 目錄夾名稱- 存放資料於HDFS中

hadoop fs -put local_file_name hdfs_file_name- 從HDFS刪除資料

hadoop fs -rmr hdfs_file_name- 查看HDFS檔案內容

hadoop fs -cat file_name- 自HDFS中,取回檔案至本地端

hadoop fs -get hdfs_file_name local_file_name程式執行指令如下:

hadoop jar jar檔 類別名稱 欲處理的檔案 計算完後結果存放之處

hadoop jar example.jar WordCount hdfs_files result_stored_folder

確認目前工作目錄為hadoop_tutorial,確認src子目錄夾中有可編譯之java檔案 於命令列模式,直接輸入 "ant",系統便會直接進行src目錄夾中檔案之編譯與jar檔包裝

ant